Tous les liens n'ont pas la même valeur aux yeux de Google

En 1997 : Tous les liens naissent libres et égaux

En 1997, les fondateurs de Google ont créé une

méthode algorithmique afin de déterminer l'importance et

la popularité des sites basée sur plusieurs principes

clés :

- Liens sur le web peuvent être interprétés comme un vote depuis la page source vers la page cible

- Tous les votes sont, dans un premier temps, considérés comme égaux

- Au cours de l'exécution de l'algorithme les pages qui reçoivent le plus de voix deviennent plus importantes

- Les pages les plus importantes votent de manière plus importantes

- Les votes qu'une page peut exprimer sont fonction de l'importance de cette page, divisée par le nombre de votes qu'elle effectue

Cet algorithme, bien sûr, vous l'avez reconnu, est celui du

PageRank. Et c'est cet algorithme qui a changé le cours de

l'histoire de la recherche sur internet. En se basant sur cet

algorithme, les SEO ont centré leurs efforts sur les liens car

pour grimper dans les résultats de recherches effectuées

via Google il fallait gagner de l'importance en obtenant le plus de

voix possible et donc recevoir le maximum de liens en provenance de

d'autres sites web. A cet époque le lien était roi !

Mais Google ne s'est pas reposé sur ses lauriers dans le domaine

de l'analyse des liens. Ils ont innové, en tirant parti des

signaux tel que le texte d'ancrage, le trustrank, les réseaux

d'influence (hubs) et les autorités de domaine. Maintenant on

évolue vers le social media et le mobile friendly.

Pourtant, beaucoup d'intervenants dans le domaine du SEO ne sont pas

encore au courant de ces changements et de leurs impacts et ils axent

toujours leurs efforts sur l'acquisition de liens externes.

Google affine ses jugements par rapport aux liens

Très précocément l'algorithme du Pagerank est

amélioré et Google s'attache à classer les liens

suivant leur importance en fonction de différents

critères et en particulier la position du lien dans la page

d'origine du lien :

- les liens les plus haut dans le code vs les liens les plus bas

- les liens internes vs les liens entrants externes

- les liens présents dans le contenu vs les liens présents dans le design et les éléments de navigation

- les liens en dur dans le texte vs les liens dans les balises images ou les balises noscript

- l'ordre des liens

- Les liens haut dessus de la ligne de flottaison vs les liens plus bas dans la page

Je vais chercher dans la suite de cet article à développer plus précisément chacun de ces critères en y apportant quand c'est possible des résultats d'expérimentations menées par des référenceurs reconnus par diverses communautés.

# 1 - Les liens les plus haut dans le code HTML sont plus puissants

Chaque fois que les référenceurs ont effectué des

tests, ils ont constaté que des liens plus haut dans le code

HTML d'une page semblent peser plus lourd dans le classement des pages

liées que ceux qui se trouvent plus bas. Cela correspond

certainement à la demande de brevet que Google a acquis,

concernant le classement de documents basées sur le comportement

de l'utilisateur et/ou les données en fonction de ce qu'il

suggère comme un certain nombre d'éléments qui

peuvent être pris en compte dans la façon dont les

paramètres sont passés en lien.

Suite aux « huit

questions sans réponse » de Rand Fishkin, Russ

Jones a divulgué le résultat de quelques

expérimentations SEO réalisées en interne.

Test 1 : L’ordre des liens a-t-il une influence sur les poids des ancres ?

Hypothèse :

Lorsqu’une page est liée plusieurs fois à partir de

la même page avec plusieurs ancres différentes, les ancres

ont une importance décroissante avec l’ordre des liens.

Réponse : Oui !

Les ancres « supplémentaires » sur une

même page sont d’abord ignorées.

Quand elles sont prises en compte, elles ont un poids

décroissant avec leur ordre dans la page.

Expérience :

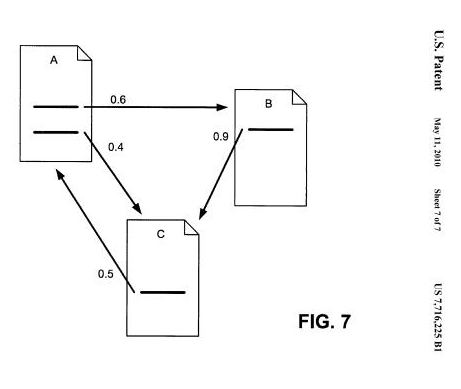

Trois sous-domaine artificiels, sur un domaine vierge, chacun

hébergeant une page de contenu aléatoire ( 750 mots

générés). Pas de title, pas de meta, et aucun des

mots clefs choisis pour les ancres n’est présent dans le

texte.

Chaque page des sous-domaine a été linkée de

l’extérieur, avec trois ancres différentes en texte

aléatoire. Les ancres ne sont présentes nulle part dans

les pages cibles.

Les liens sont fait, toujours dans le même ordre :

sous1.domaine.com/page.htm : ancre1, ancre2, ancre3

sous2.domaine.com/page.htm : ancre2, ancre3, ancre1

sous3.domaine.com/page.htm : ancre3, ancre1, ancre2

Observation :

Dans les premiers jours, une requête sur une ancre ne montre que

la page pour laquelle elle est liée avec la première

ancre. (i.e. ancre2 => sous2.domaine.com/page.htm).

Au bout de quelques temps, les trois pages sont indexées, pour

les trois ancres, mais elles ont toujours gardées l’ordre

de leur ancre. C'est à dire que pour une requête sur

l'ancre2 on aura en premier le sous-domaine 2 suivi du sous-domaine 1

et finalement du sous-domaine 3.

# 2 - Les liens externes sont plus influents que les liens internes

Il y a peu de surprise ici, mais si vous vous souvenez, le concept de

PageRank d'origine ne fait aucune mention de liens internes et externes

et comme quoi ils seraient pris en compte de manière

différente. Il est très probable que d'autres

évolutions plus récemment créées

(post-1997) visent à récompenser les liens externes plus

que les liens internes.

Je ne pense pas qu'il soit difficile d'imaginer que Google calcule

séparément dans son analyse de PageRank, le PageRank

externe et le Pagerank interne et qu'il peut potentiellement les

utiliser de différentes manières pour l'évaluation

de la page dans les classements.

Nul n'a besoin d'expériementer sur ce point ou plus exactement

on peut dire que chacun expérimente chaque jour. C'est d'une

telle évidence qu'un lien venant d'un domaine externe apporte

plus de force qu'un simple lien interne d'une page de votre site vers

une autre page de votre site, qu'il n'y a pas lieu de s'étendre

sur le sujet.

# 3 - Est ce qu’un lien qui disparaît vous nuit ?

Hypothèse :

Vous ajoutez un lien follow sur Wikipedia. Ce lien est crawlé et

pris en compte pour le positionnement de votre site.

Mais un autre l’éditeur l’enlève quelques

semaines / mois après.

Cette disparation est-elle mauvaise pour votre positionnement ?

Aurait-il mieux valu ne jamais avoir de lien ?

Réponse : Oui, si ce lien est un de vos liens les plus puissants vers la page cible.

Expérience :

Prendre une page naturelle, construire 50 liens pointant vers cette

page, et rajouter / enlever un lien de la home page d’un site

puissant et bien référencé vers cette page.

Le rythme d’ajout/disparition du lien était de 2 semaines,

sur une période de 12 semaines.

Observation :

Google suit précisement la présence ou non du lien, et

dépositionne la page en fonction.

# 4 - La diversité des domaines liants compte plus que le nombre de liens

Le nombre de domaines uniques contenant un lien externe vers une page donnée est très important dans le classement. Cela suggère fortement qu'une composante de l'algorithme est liée à la diversité des origines de liens.

Pour faire clair : il est préférable d'avoir 50 liens à partir de 50 domaines différents que d'avoir 500 liens qui ne proviennent que d'un seul site.

Curieusement encore, l'algorithme PageRank d'origine ne le prévoyait pas. C'est peut-être pour cela que les domaines recevant de nombreux liens de sites avec de nombreuses pages ayant un gros PR ont si bien fonctionné dans les premières années après le lancement de Google.

# 5 - Les liens dans le contenu transmettent plus de valeur que ceux du footer ou dans les sidebars de navigation

Un brevet que Google a déposé en 2004, et a accordé aujourd'hui, montre une approche quelque peu différente de celle du Pagerank originel, de la valeur que les liens peuvent avoir quand ils apparaissent sur la même page :

Les systèmes et les méthodes compatibles avec les principes de l'invention peuvent fournir un modèle de surf raisonnable qui indique que lorsqu'un internaute accède à un document avec un ensemble de liens, l'internaute suivra certains des liens avec une probabilité plus élevée que les autres.

Ce modèle de surf raisonnable reflète le fait que tous les liens associés à un document ne sont pas tous susceptibles d'être suivis avec la même probabilité. Des exemples de suivi peu probable de liens peuvent inclure les liens vers les "Conditions de service", des bannières publicitaires et des liens sans rapport avec le document.

Vous pouvez consulter cet article de Bill Slawski qui a fait beaucoup de bruit dans le monde du SEO : Google's reasonable surfer ...

Il semblerait que le classement des documents effectué par Google soit basé sur la distance sémantique et l'analyse développée dans cet article suggère que la valorisation des liens présents au coeur du contenu soit plus forte que ceux des encadrés ou des pieds de page en terme d'impacts positifs et qu'ils permettent de réduire le spam et la manipulation. Beaucoup de webmasters et de référenceurs peuvent certainement attester du fait que beaucoup de liens payants existent dans ces sections de pages et que l'obtention de liens non-naturels à l'intérieur du contenu est beaucoup plus difficile.

# 6 - Les mots-clés présents dans le corps du texte passent plus de valeur que ceux des attributs alt des images

Beaucoup de tests ont montré qu'il est préférable d'utiliser un texte d'ancrage en dur plutôt que les liens image. Cela ne veut pas dire que nous devrions faire uniquement des liens en dur et jeter tous les liens image à la corbeille. Il est juste bon d'être conscient que Google semble avoir cette préférence pour les liens dans le texte et c'est essentiellement du bon sens car un lien dans le texte est clairement visible par l'internaute alors qu'un lien image n'affiche le contenu de la balise alt qu'au survol de la souris.

# 7 - Les liens contenus dans les balises NoScript n'ont aucune valeur

Au fil des années, ce phénomène a été signalé et contredit de nombreuses fois. Des tests ont certainement suggéré que les liens noscript ne passent pas da valeur, mais ce peut ne pas être vrai de façon systématique. Dans tous les cas la quantité de liens global sur le web à l'intérieur cette balise est assez petite.

# 8 - La structure et l’ordre du contenu ont-ils de l’importance ?

Hypothèse :

Quelle est l’importance de la structure d’une page pour le

positionnement ? Si trois pages de qualité similaire avaient

chacune un paragraphe sur les « trucs bleus » ,

la première page ayant ce paragraphe en premier, la

deuxième comme deuxième paragraphe, et la

troisième comme troisième paragraphe, quel serait le

résultat ?

L’ordre du contenu compte : le plus haut sera le plus fort

Observations :

Russ Jones > Je trouve ridicule que certains sites puissent

être considérés comme duplicate parce que les

trente premières lignes sont les mêmes sur toutes les

pages : le menu, la navigation et l’adresse de la

société.

C’est ridicule.

Mais, sur l’un de nos plus gros sites, quand nous avons

déplacé le nuage de tags au dessus de l’article

plutôt qu’en dessous, les positionnements ont

explosé.

Des référenceurs apportent confirmation à ces affirmations > je confirme et appuie… les premières 30-50 lignes des pages sont le « pot à miel » du référenceur. Et les liens en footer une vaste plaisanterie.

# 9 - L’ordre des liens est-il pris en compte ?

Hypothèse :

Si une page avait six liens sortants avec la même ancre, vers six

pages

inconnues des moteurs, si chacune de ces pages ciblait le même

mot clef, la page ayant le premier lien serait-elle mieux

positionnée ?

Réponse : OUI !!!

Note : à méditer pour les échanges de liens !

Observations :

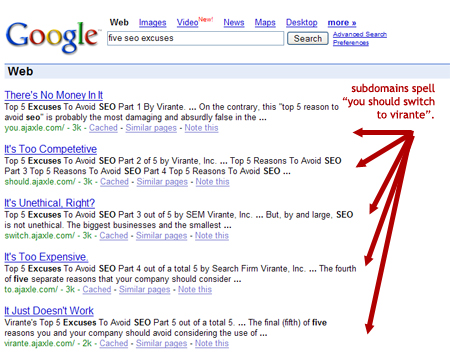

Cette question a fait l’objet d’une expérimentation in

vivo par thegooglecache.com. La même phrase,

« Five SEO Excuses » était l’anchor

de cinq sous.domaine.com/page.htm.

Le résultat se passe de commentaires :

Google améliore encore sa prise en compte des liens en fonction de leur position

Google est capable de générer la page visuellement tel

qu'un internaute pourrait la voir sur son écran. On vient

d'apprendre que les 30 à 50 premières lignes d'un contenu

étaient plus importantes que les suivantes. Pour aller plus loin

on peut ajouter la notion de ligne de flottaison. Ce qu'on appelle

ligne de flottaison est l'endroit où la page est coupée

quand on l'affiche dans un navigateur sans utiliser l'ascenseur pour la

faire descendre. Tout ce qui se trouve au dessus de cette ligne de

flottaison est donc immédiatement visible par l'internaute sans

aucune autre action de sa part.

Google semble avoir amélioré son algorithme pour donner

plus d'importance aux liens qui se trouvent au dessus de la fameuse

ligne de flottaison. Encore une fois c'est une amélioration qui

découle du bon sens. Rappelez-vous, dans le premier paragraphe de la

seconde partie de cet article je vous disais que les liens

placés le plus haut dans le code HTML avaient plus de valeur.

Mais ça c'était avant !

En effet, prenons pour exemple un tableau à 3 colonnes, un lien

placé en haut de la colonne de droite sera plus bas dans le code

HTML qu'un lien placé en bas de la colonne de gauche. Et

pourtant le lien en haut de la colonne de droite peut se trouver au

dessus de la ligne de flottaison alors que le lien tout en bas de la

colonne de gauche se trouvera bien en dessous de cette ligne de

démarcation.

Partant de ce constat je ne vois pas comment un moteur pourrait

raisonnablement donner plus d'importance à une partie

cachée qu'à une partie visible dès l'ouverture de

la page. Des améliorations ont été

apportées à l'algorithme de Google pour déterminer

les positions visuelles des liens. Différents brevets ont

été déposés par Google et ils ne

servent pas uniquement à calculer l'importance d'un lien mais

également à établir les sitelinks. On en parle

dans cet excellent

article publié sur Webrankinfo.

Mais comment prendre en compte les liens pour un affichage sur mobile ?

Le corportement des internautes tend à utiliser le plus possible les smartphones pour consulter le web. Google s'adapte à ces comportements et a depuis longtemps publié des recommandations à l'encontre des webmasters pour les inciter à réaliser des sites qui peuvent aussi bien être consultables sur un mobile que sur un ordinateur desktop. Le 21 avril 2015 Google annonce la mise en place d'un nouveau critère dans son algorithme. Il s'agit de la mise à jour Mobile-Friendly qui se résume comme ceci :

- Les sites étant mobile-friendly seront favorisés dans les résultats de recherches effectuées sur des mobiles

- Les recherches effectuées sur desktop ne seront pas impactées

Mais alors un problème se pose ! Je n'en ai pas encore la

réponse et ça reste pour moi une grande inconnue. On sait

que Google est à présent capable de simuler une

représentation visuelle de la page pour déterminer

l'emplacement des liens. Il y a dix ans Google ne s'intéressait

qu'à la position du lien dans le code HTML. A présent il

est beaucoup plus juste en s'intéressant à la position

visuelle du lien dans la page. Cette position peut différer

énormément par rapport à sa position dans le code.

Reprenons l'exemple d'un site en trois colonnes. A présent

Google peut donner plus de force à un lien qui se trouve en haut

de la troisième colonne par rapport à un lien qui se

trouve en bas de la première colonne. C'est quelque chose

d'assez logique après tout.

Mais problème il y a avec les mobiles !

La même page ne va pas s'afficher de la même façon

sur un mobile car les colonnes vont s'enchainer les unes à la

suite des autres et non de front comme sur un ordinateur de bureau.

Le lien qui se trouve donc tout en haut en droite sur un ordinateur de

bureau (parce qu'il est en haut de la troisième colonne) va se

retrouver tout en bas sur un mobile.

Alors comment Google tient-il compte de la force relative de ce lien ?

Est-ce qu'il prend en compte deux forces distinctes pour calculer deux

poids de pages différents : un qui sera utilisé pour les

recherches effectuées sur desktop et un second poids qui entrera

dans le calcul pour positionner les sites dans les pages de

résultats des recherches effectuées sur mobile ?

Je n'en sais rien....